Sécuriser les systèmes d'IA générative : 25 recommandations clés

D'après le guide de recommandations de sécurité pour les systèmes d'IA générative, publié par l'ANSSI.

L'IA générative, une branche fascinante de l'intelligence artificielle, a révolutionné de nombreux secteurs grâce à sa capacité à créer du contenu original, qu'il s'agisse de textes, d'images, ou même de musique. Cependant, cette technologie prometteuse s'accompagne de défis de sécurité significatifs. Les systèmes d'IA générative sont vulnérables aux attaques adverses, aux fuites de données et à d'autres menaces potentielles.

L'ANSSI - Agence nationale de la sécurité des systèmes d'information vient de partager un guide de recommandations de sécurité pour les systèmes d'IA générative. Il a pour objectif d'alerter et de sensibiliser les entreprises sur les risques associés à l'IA générative et à encourager l'adoption de bonnes pratiques au plus tôt.

Voici les points clés à retenir.

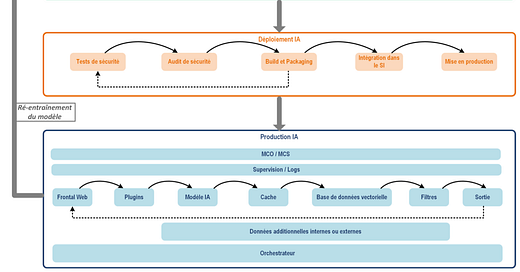

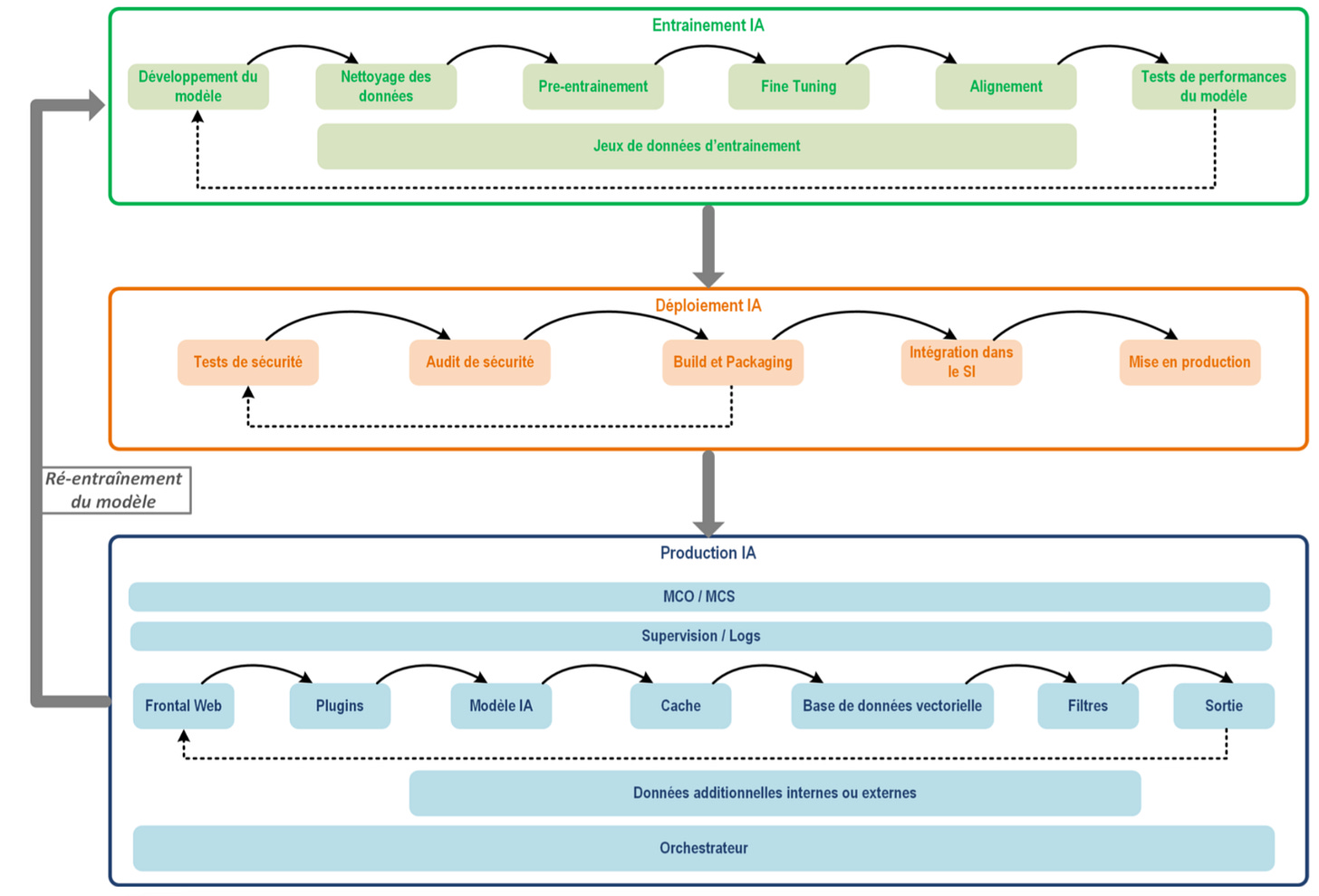

Cycle de vie d'un système d'IA générative

Un système d'IA générative est composé de trois grandes phases :

l'entraînement,

le déploiement,

et la production.

Chacune de ces étapes a ses propres défis de sécurité.

Phase d'entraînement

Pendant l'entraînement, on utilise beaucoup de données, souvent sensibles. Il faut absolument sécuriser ces environnements pour éviter les fuites et les manipulations. Assurez-vous que les données sont chiffrées et que seules les personnes autorisées peuvent y accéder.

Phase de déploiement

Lors du déploiement, le modèle passe de l'environnement de développement à celui de production. À ce stade, il est exposé à plus de monde ; il faut donc contrôler les accès et surveiller les interactions pour repérer toute anomalie. Limitez les connexions au strict nécessaire pour réduire les risques.

Phase de production

Enfin, en production, le modèle génère du contenu en temps réel. Ici, il faut mettre en place des systèmes de surveillance et de contrôle pour s'assurer que tout se passe bien et qu'aucune information sensible ne fuite. Faites des audits réguliers et mettez à jour les systèmes pour rester à jour sur les nouvelles vulnérabilités.

Les 3 scénarios d’attaques spécifiques aux IA génératives

Les IA génératives peuvent être la cible d'attaques, où des intrus essaient de perturber leur fonctionnement ou de voler des données. La confidentialité et la sécurité des interactions utilisateur-modèle sont cruciales.

Ces menaces peuvent être déclinées en 3 grandes catégories d’attaques :

Attaques par manipulation qui consistent à détourner le comportement du système d’IA en production au moyen de requêtes malveillantes. Elles peuvent provoquer des réponses inattendues, des actions dangereuses ou un déni de service ;

Attaques par infection qui consistent à contaminer un système d’IA lors de sa phase d’entraînement, en altérant les données d’entraînement ou en insérant une porte dérobée ;

Attaques par exfiltration qui permettent de dérober des informations sur le système d’IA en production, comme les données ayant servi à entraîner le modèle, les données des utilisateurs ou bien des données internes du modèle (paramètres).

Intégration du système d’IA dans le SI

La sécurité doit être réfléchie à toutes les étapes du cycle de vie d'un système d'IA, incluant la sécurisation des interactions entre le système et les autres applications ou composants internes et externes.

PODCAST - Interview exclusive de la CTO de BPI France “Pas de Data, pas d’IA”

Dans le dernier épisode du podcast IA pas que la Data, produit par Flint, nous avons eu le plaisir d’accueillir Ludi Akue, CTO Digitale de BPI France. Au programme :

🏗️ Quel socle data solide pour démarrer des projet IA / Gen AI ?

👑 Rester souverain malgré les lacunes de la filière hardware française / européenne

👀 Construire une IA frugale

💸 Gestion des coûts des projets Gen AI

13 recommandations générales

Évaluer le niveau de confiance des bibliothèques et modules externes utilisés dans le système d'IA. Il est recommandé de cartographier l’ensemble des bibliothèques et modules utilisés dans le cadre du projet.

Évaluer le niveau de confiance des sources de données externes utilisées dans le système d’IA.

Appliquez les principes DevSecOps sur l'ensemble des phases du projet, afin de garantir un développement sécurisé sur l’ensemble des phases du projet.

Utiliser des modèles d’IA sécurisés. Utilisez des formats à l’état de l’art du point de vue de la sécurité, comme le format Safetensor par exemple. Les formats Pickle sont à proscrire.

Prendre en compte les enjeux de confidentialité des données dès la conception du système d’IA, et à chaque phase du système d’IA (entraînement, déploiement et production).

Proscrire l’usage automatisé de systèmes d’IA pour des actions critiques sur le SI.

Maîtriser et sécuriser les accès à privilégies des développeurs et administrateurs.

Héberger le système d’IA dans des environnements de confiance cohérents avec les besoins de sécurité.

Implémenter une passerelle Internet sécurisée dans le cas d’un système d’IA exposé sur Interne.

Privilégier un hébergement SecNumCloud dans le cas d’un déploiement d’un système d’IA dans un cloud public.

Prévoir un mode dégradé des services métiers sans système d’IA.

Dédié les composants GPU au système d’IA.

Prendre en compte les attaques par canaux auxiliaires sur le système d’IA.

Recommandations pour la phase d'entraînement

La phase d'entraînement est fortement sujette aux attaques telles que l’injection de données malveillantes. Voici quelques recommandations afin de travailler dans des environnements sécurisés pour protéger vos données.

Entraîner un modèle d’IA uniquement avec des données légitimement accessibles par les utilisateurs.

Protéger en intégrité les données d'entraînement du modèle d’IA. Cela peut prendre la forme d'une vérification systématique de la signature ou empreinte des fichiers utilisés.

Protéger en intégrité les fichiers du système d’IA

Proscrire le ré-entraînement du modèle d’IA en production.

Recommandations pour la phase de déploiement

La phase de déploiement de système d’IA doit s'appuyer sur un environnement de déploiement sécurisé reposant sur des chaînes de CI/CD maîtrisées et renforcées. Pour cela, l’ANSSI vous conseille :

Sécuriser la chaîne de déploiement en production grâce à un déploiement depuis un SI d’administration

Prévoir des audits de sécurité avant déploiement en production, via des tests de robustesse et de sécurité des systèmes d’IA.

Prévoir des tests fonctionnels métier avant déploiement en production, tels que des tests de performance et de qualité des réponses apportées par un système d’IA générative.

Recommandation pour la phase de production

En production, le modèle génère du contenu en temps réel, nécessitant des mécanismes de surveillance et de contrôle pour assurer la sécurité et la conformité.

Voici quelques recommandations :

Protéger le système d’IA en filtrant les entrées et les sorties des utilisateurs.

Maîtriser et sécuriser les interactions du système d’IA avec d’autres applications métier. L’ensemble des interactions doivent être documentés.

Proscrire les actions automatiques sur le SI déclenchées depuis un système d’IA et à partir d’entrées non-maîtrisées.

Cloisonner le système d’IA dans un ou plusieurs environnements techniques dédiés.

Journaliser l’ensemble des traitements réalisés sur le système d’IA

Sécuriser les systèmes d'IA générative est un défi, mais c'est essentiel pour profiter pleinement de cette technologie tout en protégeant nos données et nos infrastructures. En suivant ces recommandations, nous pouvons mettre en place des mesures de sécurité solides et assurer une utilisation sûre et efficace des IA génératives. Restons vigilants et proactifs pour sécuriser nos innovations technologiques !

Vous souhaitez être accompagné dans votre démarche Gen AI ? Nos experts peuvent vous accompagner aux différentes étapes de votre process. Découvrir notre offre GenAI.

Si vous avez aimé ce contenu, abonnez et/ou à recommandez Flint👇